どんなときに注意が必要なのか

欠損データに対処するための戦略¹

Indeed のミッションは、「We help people get jobs (求職者の仕事探しのお手伝い)」です。仕事探しはストレスがたまることも多いでしょう。だからこそ、Indeed ではより簡単なプロセスを常に模索し、サービスを改善し続けています。Indeed のサービスや求人検索エクスペリエンスについて求職者がどう思っているかは、アンケートを使用して知ることができます。

アンケートからわかったことは、仕事を探している人 (あるいは見つけたばかりの人) にとって、アンケートへの回答は、最もやりたくないことだということでした。つまり、Indeed が収集するアンケートのデータの多くは、欠損データであるということになります。ユーザー満足度などのアンケートを正しく分析するには、潜在的な欠損パターンを考慮に入れ、正しい結論を導き出す必要があります。

ここでは、欠損データを特定し、どう対処するかについてお話したいと思います。ミシガン大学でのアンケートの手法に関するトレーニングに触発され、学問として学んだデータセットに関する理論を、Indeed の膨大なデータに応用したいと考えるようになりました。

先日まで携わっていた欠損データを扱うプロジェクトでは、分析から多くのことを学びました。一通りのプロセスをご紹介しますので、Indeed がどのようにアンケートのデータを収集しているか、おわかりいただけると思います。非回答率と非回答バイアスの違いや、なぜ非回答バイアスにおいて「ランダム性」が良いとされるのか、具体例を用いてご説明します。

注意: この記事で使用する例は Indeed に関するものですが、扱うデータはすべて架空のものであり、筆者である私が作り上げました。

Indeed での採用数の測定

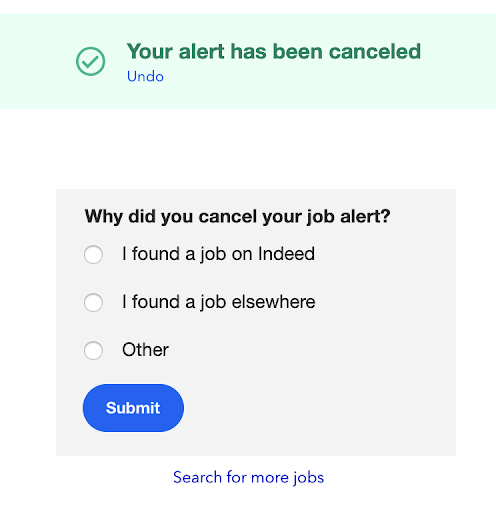

Indeed からのジョブアラート (新着求人情報のメール配信) の配信を停止したことがある方は、次のアンケートをご覧になったかもしれません。

このアンケートの目的は、求職者がジョブアラートをキャンセルまたは配信停止した理由が、仕事が見つかったからなのかを確かめることです。この情報があれば、Indeed のサービスの改善に役立ちますし、求職者の成功を祝うことができます。

このアンケートには、一部の求職者しか回答してくれない、という問題点があります。ユーザーの視点で考えれば当然のことでしょう。おそらく、メールの配信は停止しても、アンケートへの回答には時間を使いたくないのです。これは私たちにとって、特に「仕事が見つかったから配信を停止したのか」というキーとなる質問に関しては、かなりの数の欠損データが生じることを意味しています。

非回答率と非回答バイアス

欠損データについて議論する際、回答率と非回答バイアスを混同しがちです。回答率に関してこういう誤解があると、データの質の問題に発展してしまいます。回答率が高い方が、回答の質が高いと思い込んでしまうことがあるのです。しかし、必ずしもそうではありません。

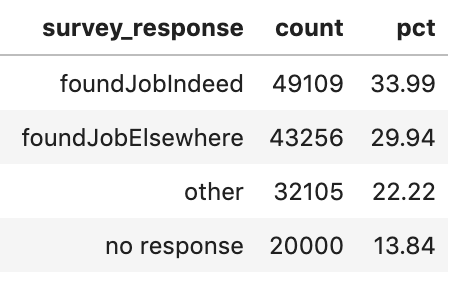

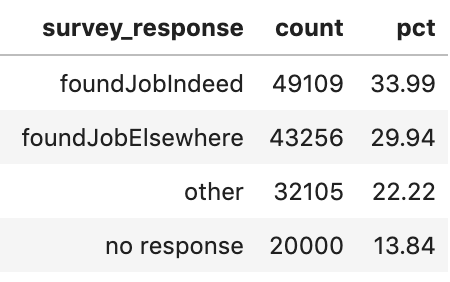

ジョブアラートのキャンセルに関するアンケートの結果を見ると、13.8%が回答していないことがわかります。

非回答率が13.8%であるということは、アンケートの回答の質について何かを示唆していると言えるでしょうか?

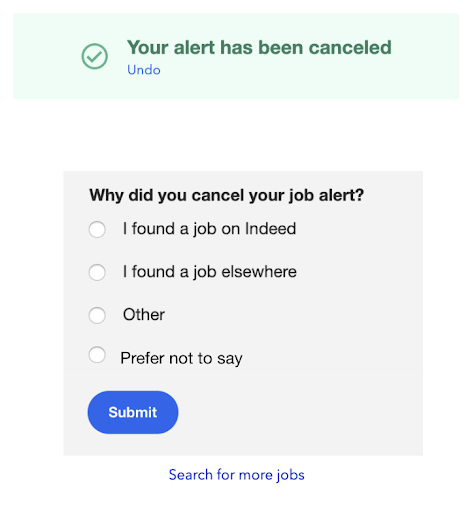

答えはノーです。この時点では、直観的には受け入れがたい回答かもしれませんが、しばしお付き合いください。Indeed がジョブアラートキャンセルのアンケートを改訂し、「答えたくない」という選択肢を加えたとしましょう。

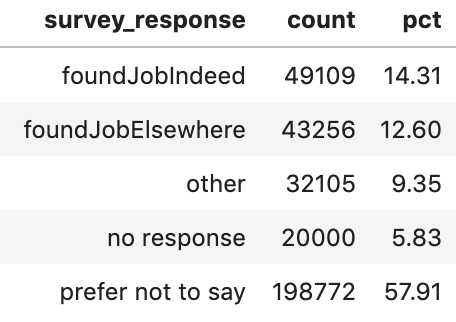

数週間にわたってデータを収集したところ、改訂後のアンケートに答えなかった求職者はわずか5.8%でした。

これは、有益なデータが増えたと言えるでしょうか? 非回答率が8%減ったことを喜ぶ前に、回答の分布を詳しく見てみましょう。「答えたくない」を選んだ求職者が57%もいます。

通常、「答えたくない」という回答は欠損データとして扱います。求職者が「答えたくない」を選んだ理由が、採用の最終段階に入っているからなのか、別の理由 (たとえば、他の仕事に応募していることを現在の雇用主に知られる可能性がある、など) なのかはわかりませんが、この場合、回答バイアスが生じている可能性があります。

回答バイアスとは、社会的欲求や圧力により、「答えたくない」など、特定の回答を選択してしまうバイアスです。非回答バイアスは、参加バイアスとも呼ばれ、社会的欲求や圧力により、アンケートへの回答を拒むことを意味します。

上記の例には回答バイアスが見られます。質問がセンシティブな性質を持っているために回答者が「答えたくない」を選んだ可能性があるからです。回答者がアンケートに全く答えなかった理由がアンケートの性質であった場合、非回答バイアスが生じるでしょう。

これは、アンケートに回答した人の割合など、非回答率だけがデータの質を表すものではないことを示しています。

たとえば、過去のアンケートの回答率が80~90%だったのに、直近では61%であった場合、この数字は、非回答率に関する問題が生じている可能性を調べる論拠としては十分でしょう。しかし、過去の回答率が3~5%で、直近では4%であれば、そのアンケートに非回答率の問題はない可能性が高くなります。その代わり、アンケートの提供方法 (固定電話と携帯電話のどちらでデータを集めるか) や参加者の特定方法 (連絡先が古い、あるいは不正確である) についての戦略が、全体的な回答率を下げているかもしれません。

回答率が3%であっても61%であっても、回答率は低回答バイアスと同義ではないのです。改訂後のアンケートの結果、回答率が高い時でも、半数以上の回答者は「答えたくない」を選んだことがわかりました。データ分析には役に立たない回答です。

アンケートに回答した人数に注意を払うだけでなく、質問別の回答数の分布も調べる必要があります。データの特異性や潜在的なバイアスに気付くには、シンプルな度数の統計が非常に役立ちます。

ランダムな欠損とランダムでない欠損

非回答バイアスは、簡単に言えば、欠損データがランダムか、ランダムでないかの問題です。どちらの可能性を採るかによって、分析結果が異なります。

最悪のシナリオ: MNAR

欠損データに関する最悪のシナリオは、ランダムでない欠損 (MNAR)[2] [3] [4] です。MNAR の場合、欠損データは一つ以上の変数と相関関係があり、欠損は、おそらく質問の性質がセンシティブであることに起因しています。これは、アンケートの作成方法に問題が潜んでいることを示しています。

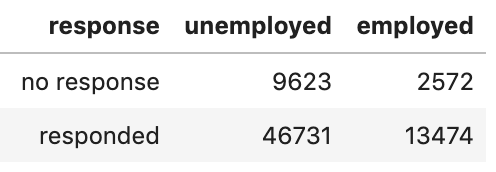

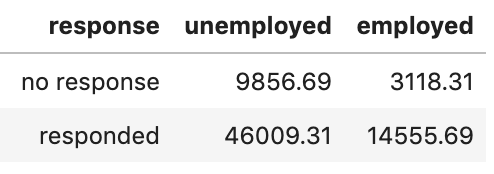

たとえば、ジョブアラートキャンセルのアンケートでカイ二乗検定を行い、アンケートの回答 (回答なし vs あり) と現在の雇用状況 (就業中 vs 失業中) の関係を検証したとしましょう。次のような結果が得られるのではないでしょうか。

この結果は、ジョブアラートキャンセルのアンケートへの回答と求職者の現在の雇用状況の間に、統計的に大きな関連性があることを示しています。これにより、検定統計量が 𝚾²(1) = 9.70、有意確率が p = 0.0018だとわかりました。つまり、ジョブアラートキャンセルのアンケートの回答者のうち、失業中の人の割合は、ランダムに予想したよりもはるかに多かったのです。

これは「ランダムでない欠損」の例です。回答の選択に、アンケートの質問そのものが影響した可能性がああるからです。失業している人にとっての職探しは非常に深刻な問題なので、失業中の求職者は、ジョブアラートキャンセルのアンケートに回答する傾向にあるのかもしれません。

最良のシナリオ: MAR

欠損データに関して最も良いシナリオは、ランダムに欠損していること (MAR)[5] [6] です。MAR の場合は、欠損データは少なくとも一つの変数と相関関係にあり、欠損の原因はアンケートの質問そのものではありません。

私が読者を混乱させるために、わざと専門用語を使っていると思われるかもしれません。実際その通りで… という冗談はさておき、MNAR と MAR は、調査方法論学者が欠損データについて議論する際によく使う用語です。MNAR と MAR は、第一種の過誤と第二種の過誤、媒介と調整といった専門用語と同じ世界に属しています。

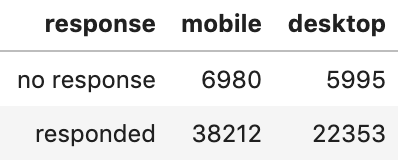

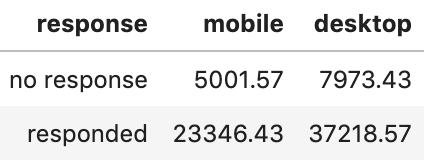

たとえば、ジョブアラートキャンセルのアンケートでカイ二乗検定を行い、アンケートの回答 (回答なし vs あり) と求職者が使用するデバイス (デスクトップ vs モバイル) の関係を検証したとしましょう。これにより、検定統計量が X²(1) = 75.57、有意確率が p < .0001 だとわかりました。次のような結果が得られるのではないでしょうか。

この結果は、ジョブアラートキャンセルのアンケートに回答する求職者と求職者のデバイスの間に、統計的に大きな関連性があることを示しています。デスクトップコンピューターを使用している求職者がジョブアラートキャンセルのアンケートに回答した割合は、予想よりもかなり少ないものでした。

しかし、これまでの経験から考えると、デスクトップよりもモバイルデバイスで求人を検索する求職者の方が多いのかもしれません。この場合、欠損は、アンケートの質問そのものではなく、デバイスの好みに起因している可能性があります。

欠損データに関するその他のシナリオ

このシナリオには、完全にランダムにデータが欠損しているケースや、意図的にデータを欠損させているケースなどがあります。

完全にランダムな欠損 (MCAR) [7] [8] は、欠損が他のどの変数とも相関関係を持たないケースのことを言います。通常、Web 分析で得られるような大規模で複雑なデータセットで、このような欠損を検証するのは不可能です。大規模なデータセット、特に急速に拡大するデータセットの場合は、不確かではあるが顕著な相関関係を見つけられる可能性は、ほぼ100%です。

意図的な欠損とは、欠損データを意図的に生じさせているケースのことを指します。たとえば、過去30日間に Indeed で求人に応募した求職者にのみ、ジョブアラートキャンセルのアンケートを表示するように変更したとしましょう。このシナリオでは、過去30日間に求人に応募していない求職者には、アンケートは表示されません。したがって、応募数に基づいて意図的にデータを欠損させることになります。

欠損データに対処する際の課題

欠損データの大きな課題は、ランダムに欠損しているのか否かの判断で、ランダムであれば MNAR と MAR のどちらかであるかを判断することです。欠損データの分布において大きな差異を確認するのは比較的簡単ですが、有意確率と信頼区間だけでは、なぜデータが欠損するのかはわかりません。

データが MNAR なのか MAR かを判断するのは大変な作業であり、主に推測に頼るしかないのです。前述の MAR の例では、ユーザーはデスクトップ版よりモバイル版の Indeed を使う傾向にあることが、欠損の原因だと推定しました。しかし、このパターンが存在することがわかったのは、デスクトップよりもモバイルを好むユーザーにおいて類似のパターンが見られることに気づいた人たちと話をする機会があったからです。これを知らなければ、私たちは簡単にパターンの解釈を誤ったかもしれません。

幸い、データが MNAR なのか MAR なのかの診断に使用できる戦略があります。

まず、自分自身にこう問いかけてみましょう。

「その質問は、センシティブな、あるいは社会的に望ましくない行動を回答者に求めることになりますか?」

イエスの場合、センシティブな情報の開示を求めることは、MAR でなく MNAR のデータを導き出す可能性が高いことに注意してください。回答者の秘密が守られることを保証し、他の戦略も使用して回答者から信頼を得ることで、アンケートの作成方法による影響を軽減できるかもしれません。

センシティブな情報の開示を求める質問ではなくても、欠損データが MNAR (悪い方) になる心配がある場合は、他の戦略を試してみるのが良いでしょう。回答者から長期的なデータを得られる場合は、非回答パターンが過去の別の時点における回答と一致しているか確認してみてください。一致していれば、少なくとも、珍しい結果ではないことがわかります。

もちろん、非回答パターンが一致するからといって、そのデータが MNAR なのか MAR かを明確に言い当てられるわけではありません。たとえば、社会的に望ましくない行動を報告するよう求めた場合は、同じ MNAR のパターンが長期的に表れる可能性が高くなります。

長期的なデータが入手できない場合の2つ目のソリューションとしては、チーム内や社内の人に聞いてみたり、関連する研究についての論文を読んで、他に類似する非回答パターンの観測例がないか確認してみることです。Slack などのソーシャルメディアで、同僚たちにクラウドソースするのも良いでしょう。今回の非回答パターンが典型的なものなのか、そうでないのかがわかるかもしれません。

こうした比較的シンプルな yes/no ロジックは完璧とは言えませんが、このような戦略は「欠損データは重要ではない」という現実逃避的なアプローチよりは良いはずです。

欠損データはすべての終わりとは限らない

欠損データは、必ずしもすべてが回答バイアスに結びつくわけではありません。意図的な欠損、完全にランダムな欠損 (MCAR)、ランダムではない欠損 (MNAR)、あるいはランダムな欠損 (MAR) の場合もあるでしょう。ジョブアラートキャンセルのアンケートでは、アンケートの作成方法によって、欠損のシナリオが異なる可能性があることがわかりました。

あなたはデータサイエンティストですか? あるいは批判的な考え方をするデータ愛好家でしょうか? いずれにしても、手元にある欠損データについて、深く掘り下げることを忘れないでください。

おすすめの書籍

De Leeuw, E. D. (2001年) Reducing missing data in surveys: An overview of methodQuality and Quantity, 35(2), 147–160. ← 欠損データと回答バイアスについての簡潔な記事

Kish, L. (1997年) Survey sampling ← やや難解だが、サンプリングバイアスについて詳しく学ぶうえで信頼性の高い本

Tourangeau, R.、& Yan, T. (2007年) アンケートでのセンシティブな質問Psychological bulletin (心理学紀要), 133(5), 859

筆者紹介

私自身のバックグラウンドを少しお話しますと、ミシガン大学の博士課程を修了した後、Indeed の Quantitative UX Researcher として少し前に産業界に入りました。

学問の世界から産業界に移った経緯についてお聞きになりたい方、あるいは欠損データについて詳しく知りたい方は、お気軽にメッセージをお寄せください。

Indeed で働きませんか?募集中の職種をご覧ください。

[1] 非回答バイアスというトピックは、きわめて広大な分野だと言えます。書籍や論文などを入手できます。この分野についてより深く理解したい方は、上記のおすすめ書籍をチェックしてみてください。欠損データを扱う際に参照できるリソースです。